Digitaler Zwilling: Reale Anlage und digitales Abbild in der Simulation bewegen sich synchron durch OPC UA-Kommunikation (Bild: Fraunhofer IFAM)

17.06.2025 Digitale Transformation: Kommunikation im modernen Klebprozess

In der modernen Klebtechnik sind Dosieranlagen, Klebroboter und Sensortechnik essenzielle Komponenten, um eine effiziente und genaue Applikation des Klebstoffs zu gewährleisten. Geräte unterschiedlicher Hersteller verwenden allerdings oft verschiedene oder proprietäre Schnittstellen.

Trotz dieser Diversität lässt sich die Interoperabilität der Geräte im herkömmlichen Betrieb – ohne die Einführung von Industrie-4.0-Technologien – aufgrund etablierter Industriestandards, wie z.B. Siemens oder Beckhoff SPS, i.d.R. effektiv sicherstellen. Herausfordernder wird es jedoch, wenn Maschineninformationen über High-Level-Schnittstellen an externe Systeme, wie z.B. Desktop-Anwendungen, übermittelt werden sollen, um darauf aufbauend komplexere Datenanalysen durchzuführen. Zwar existieren spezifische Bibliotheken, z.B. für SIMATIC und Profinet, die eine Integration in Python-Anwendungen ermöglichen, jedoch decken diese oft nur Teilaspekte der jeweiligen Schnittstellen ab. Zudem stehen derartige Bibliotheken nicht für alle Schnittstellen zur Verfügung, die in industriellen Klebanlagen zum Einsatz kommen. Eine weitere, nicht minder relevante Herausforderung besteht darin, dass die Semantik der Daten bei der Verwendung von Low-Level-Schnittstellen im Kommunikationsprotokoll nicht berücksichtigt wird, obwohl dies für Industrie-4.0-Anwendungen von zentraler Bedeutung ist.

Eine vielversprechende Lösung bietet in diesem Kontext die Etablierung offener, durchdachter Kommunikationsstandards wie OPC UA (Open Platform Communications Unified Architecture). Dieses Protokoll erfreut sich zunehmender Verbreitung in der industriellen Praxis und berücksichtigt zahlreiche Aspekte, die für Geräte im Umfeld des Industrial Internet of Things (IIoT) von Relevanz sind. So unterstützt es z.B. Sicherheitsmechanismen wie Datenverschlüsselung, Authentifizierung und Nutzerrollen, welche angesichts der immer wichtiger werdenden Thematik der Cybersicherheit unverzichtbar sind. Darüber hinaus ermöglicht OPC UA die Übertragung von Meta-Informationen zu den gesendeten Daten, wodurch die Herausforderung der fehlenden Datensemantik adressiert wird. Im Gegensatz zu Standards wie Profinet ist OPC UA zudem plattformunabhängig und unterstützt neben speicherprogrammierbaren Steuerungen (SPS) und eingebetteten Systemen auch gängige Desktop-Betriebssysteme wie Windows, Linux und macOS, die häufig für fortschrittliche Datenanalysealgorithmen und Anwendungen der Künstlichen Intelligenz (KI) Verwendung finden.

Die erweiterten Funktionalitäten von OPC UA bringen jedoch auch gewisse Nachteile mit sich: Der mit der zusätzlichen Datenübertragung einhergehende Overhead limitiert die Echtzeitfähigkeit dieses Protokolls. Aus diesem Grund bevorzugen Anwendende für zeitkritische Low-Level-Kommunikationsanforderungen weiterhin bewährte Standards, die nicht im Kontext von Industrie 4.0 entwickelt wurden. Um dennoch von den Vorteilen von OPC UA zu profitieren, gewinnen hybride Systemarchitekturen zunehmend an Bedeutung. Bei diesen erfolgt die maschinennahe Kommunikation nach wie vor über klassische Low-Level-Protokolle wie Profinet oder EtherCAT, während OPC UA für den übergeordneten Informationsaustausch, etwa zur Datenanalyse oder Zustandsüberwachung, eingesetzt wird. Hersteller wie Siemens oder Beckhoff haben bereits begonnen, OPC UA in einige ihrer Steuerungssysteme zu integrieren, was die Einbindung in solche hybriden Architekturen erleichtert. Im Projekt „DigiKleb“ geht man noch einen Schritt weiter. Hier werden sowohl Profinet (Low-Level) wie auch OPC UA als Kommunikationsstandard parallel nebeneinander verwendet, die per Knopfdruck umschaltbar gestaltet sind. Hier kann durch Analyse der aufgezeichneten Daten ein Vergleich der Performance der Kommunikationsstandards ermöglicht werden. In einem nächsten Schritt sind dann die durch die Analyse ermittelten Schwachstellen bei der Kommunikation (mangelnde Echtzeitfähigkeit), durch eine echte Hybrid-Kommunikation vermeidbar, indem die zeitkritischen Signale auch auf die Low-Level-Standards gemappt werden und gleichzeitig noch zur Analyse über den OPC UA-Stream zur besseren Lesbarkeit an die High-Level-Clients verteilt werden.

Die erfolgreiche Digitalisierung von Klebprozessen erfordert eine präzise Erfassung und kontinuierliche Überwachung aller relevanten Prozessparameter. In Wissenschaft und Wirtschaft fehlt jedoch bislang ein systematisches, ganzheitliches Konzept zur Abbildung dieser Parameter. Obwohl die theoretischen Zusammenhänge zwischen variablen Einflussfaktoren und qualitätsrelevanten Kriterien, wie etwa der Klebfestigkeit, isoliert betrachtet weitestgehend erforscht sind, mangelt es in der praktischen Anwendung an ausreichend fundierten Erkenntnissen darüber, welche Parameter auf welche Art und Weise zu erfassen sind. Dies betrifft z.B. die Messgenauigkeit, die Anzahl der einzusetzenden Sensoren und die erforderliche Messfrequenz. Eine unzureichend definierte Datenerfassung kann dazu führen, dass potenzielle datenanalytische Vorteile, die die Digitalisierung bieten würde, nicht vollständig ausgeschöpft werden.

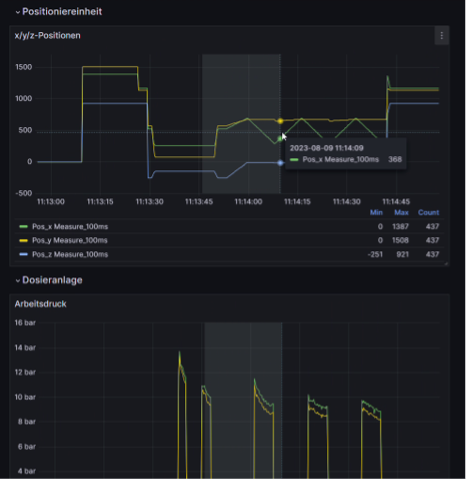

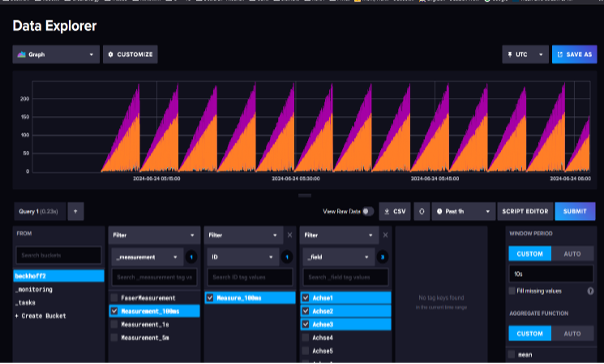

Ein wesentliches Problem tritt hierbei im Bereich der Qualitätssicherung auf, da die objektive Bewertung der Qualität einer Klebverbindung erheblichen Herausforderungen unterliegt. Um die resultierende Qualität zuverlässig abschätzen zu können, ist es erforderlich, bereits vor und während des Klebvorgangs eine Vielzahl an Prozessparametern zu erfassen. Hier bieten sich Zeitreihen-Datenbanken, wie z.B. InfluxDB, an, die in der Lage sind, den kompletten OPC UA-Datenstrom aufzuzeichnen und gezielt zu filtern. Die gesammelten Parameterdatensätze aller Geräte, die während der Klebstoffapplikation beteiligt sind, stehen dann zur Auswertung, Optimierung und Qualitätssicherung zur Verfügung. Im laufenden Betrieb muss neben der Erfassung der relevanten Einflussparameter auch die Regelung von Parametern in Echtzeit erfolgen. Dabei gibt es zwei Herausforderungen: Theorie und Umsetzung. Zunächst muss theoretisch bekannt sein, wann und mit welcher Frequenz die Parameter abzutasten und zu justieren sind. Dazu ist eine ganzheitliche Abbildung des Klebprozesses als „Digitaler Zwilling“ notwendig, um alle relevanten externen Einflussfaktoren, wie Temperatur, Luftfeuchte und Klebstoffeigenschaften, wie auch die internen Steuerungsparameter der beteiligten Geräte, zu berücksichtigen (siehe dazu Teil 2 der Reihe).

Bei einem „Digitalen Zwilling“ handelt es sich zum einen um ein Abbild auf Datenbasis („Digitaler Schatten“) in Form einer Datenbank wie auch um ein Abbild auf visueller Basis („Digitales 3D-MockUp“) zur virtuellen Inbetriebnahme und Überwachung des Klebprozesses als Computersimulation parallel zur realen Klebzelle. Für die Parametrisierung kommt der „Digitale Schatten“ auf Datenbasis zum Einsatz. Auf der praktischen Seite muss der Digitale Zwilling des Klebprozesses in der Lage sein, diese theoretischen Vorgaben zur Regelung der Parameter in Echtzeit umzusetzen. Für eine angepasste Regelung des Klebprozesses („Adaptive Control“) müssen die Zielwerte der Stellparameter rechtzeitig und kontinuierlich berechnet werden. Diese Berechnung erfolgt mithilfe von Algorithmen, die aus aktuellen und bisher aufgezeichneten Prozesswerten bestimmte Verhaltensmuster des Klebprozesses erkennen und die Regelung der Stellparameter intelligent anpassen („Machine Learning“, KI). Diese Algorithmen unterstützen den Prozess auch hinsichtlich der Erkennung von auftretenden Anomalien, die in der Zukunft möglicherweise zum Ausfall der Anlage führen könnten („Predictive Maintenance“). Insgesamt bleiben Parametrisierung und Regelung eine zentrale Herausforderung, die mit einem intelligenten Zusammenspiel aus Datenverarbeitung, Modellierung und Performance-Optimierung bewältigt werden muss.

Digitaler Daten-Zwilling: Visualisierung der Daten mit Grafana

(Bild: Fraunhofer IFAM)

Aufzeichnung der Daten mit InfluxDB (Bild: Fraunhofer IFAM)

Die Kommunikation von digitalen Prozessen braucht Regeln und eine solide Datenbasis – eigentlich ist es wie bei der Kommunikation zwischen Menschen.“ Frank Mohr, DVS®-EWF-European Adhesive Engineer, Fraunhofer IFAM